Pendahuluan

Teknologi Artificial Intelligence (AI) berkembang dengan sangat cepat. Saat ini, AI digunakan dalam keuangan, kesehatan, transportasi, hingga keamanan. Bahkan, AI mulai membuat keputusan penting dalam kehidupan manusia, seperti persetujuan pinjaman, diagnosis penyakit, hingga rekomendasi hukum.

Namun, seberapa jauh kita bisa mempercayai AI? Apakah AI bisa memberikan keputusan yang adil dan akurat, atau justru bisa menyebabkan masalah baru? Artikel ini akan membahas tantangan etika AI, risiko penggunaannya, dan bagaimana kita bisa memastikan AI bekerja secara bertanggung jawab.

Apa Itu Etika AI?

a. Definisi Etika AI

Etika AI adalah prinsip moral dan aturan yang mengatur bagaimana AI digunakan dengan cara yang adil, transparan, dan bertanggung jawab.

Etika AI bertujuan untuk memastikan bahwa AI tidak membahayakan manusia, tidak diskriminatif, dan bisa dipercaya dalam pengambilan keputusan.

b. Mengapa Etika AI Penting?

AI kini memengaruhi banyak aspek kehidupan, dari pencarian pekerjaan, layanan kesehatan, hingga keamanan publik. Jika AI tidak diatur dengan baik, maka dapat terjadi:

❌ Diskriminasi – AI bisa memberikan keputusan yang tidak adil.

❌ Kurangnya transparansi – Tidak ada yang tahu bagaimana AI membuat keputusan.

❌ Penyalahgunaan – AI bisa digunakan untuk memata-matai atau mengontrol masyarakat.

Karena itu, kita perlu memastikan bahwa AI bekerja secara adil dan etis.

Sejauh Mana Kita Bisa Mempercayai AI?

a. AI dalam Pengambilan Keputusan

AI saat ini digunakan untuk mengambil keputusan dalam berbagai bidang, seperti:

🔹 Sistem keuangan – Menentukan apakah seseorang layak mendapatkan pinjaman.

🔹 Kesehatan – Membantu dokter dalam diagnosis penyakit.

🔹 Sistem hukum – AI digunakan dalam analisis kasus hukum.

Namun, apakah AI benar-benar bisa dipercaya?

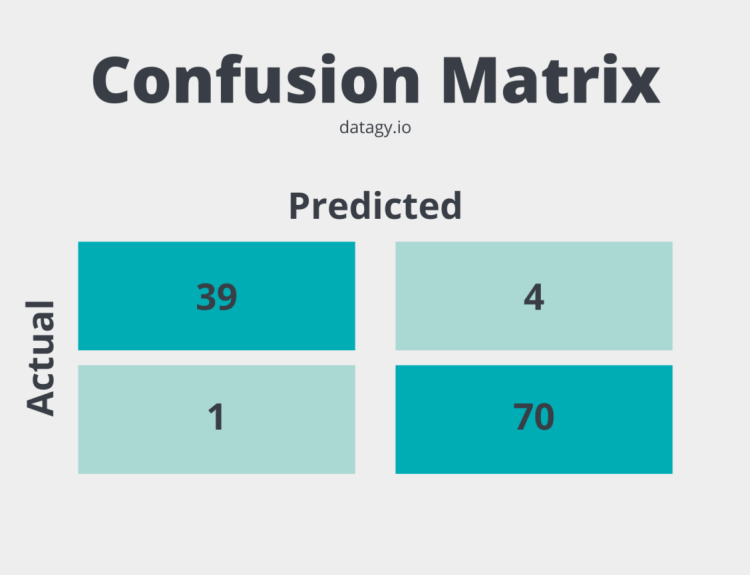

b. Risiko Bias dalam AI

AI belajar dari data manusia, tetapi jika data yang digunakan mengandung bias atau ketidakadilan, maka AI juga akan memberikan hasil yang bias.

📌 Contoh:

- AI untuk rekrutmen kerja lebih sering memilih laki-laki karena datanya berasal dari industri yang didominasi laki-laki.

- AI dalam sistem hukum memberikan hukuman lebih berat kepada kelompok minoritas karena datanya berasal dari sistem yang sudah bias.

Jika AI tidak dikontrol dengan baik, ia bisa memperkuat ketidakadilan sosial.

c. Transparansi dan Akuntabilitas AI

Banyak sistem AI bekerja seperti black box – kita tidak tahu bagaimana AI membuat keputusan. Jika terjadi kesalahan, siapa yang harus bertanggung jawab?

📌 Contoh:

- Jika AI dalam kendaraan otonom menyebabkan kecelakaan, siapa yang harus disalahkan? Produsen mobil, pengembang AI, atau pengguna?

- Jika AI salah mendiagnosis penyakit, apakah tanggung jawab dokter atau sistem AI?

Transparansi dalam AI sangat penting agar manusia tetap bisa mengontrol dan memahami bagaimana AI bekerja.

Risiko dan Tantangan dalam Kepercayaan terhadap AI

a. Ketergantungan Berlebihan pada AI

Jika kita terlalu percaya pada AI, kita mungkin akan mengabaikan peran manusia dalam pengambilan keputusan.

📌 Contoh:

- Mobil otonom yang mengalami kecelakaan karena pengemudi terlalu percaya dan tidak memperhatikan jalan.

- AI dalam deteksi kanker yang salah mendiagnosis pasien, tetapi dokter tidak mengecek ulang karena sudah percaya pada AI.

AI sebaiknya digunakan sebagai alat bantu, bukan sebagai pengganti keputusan manusia.

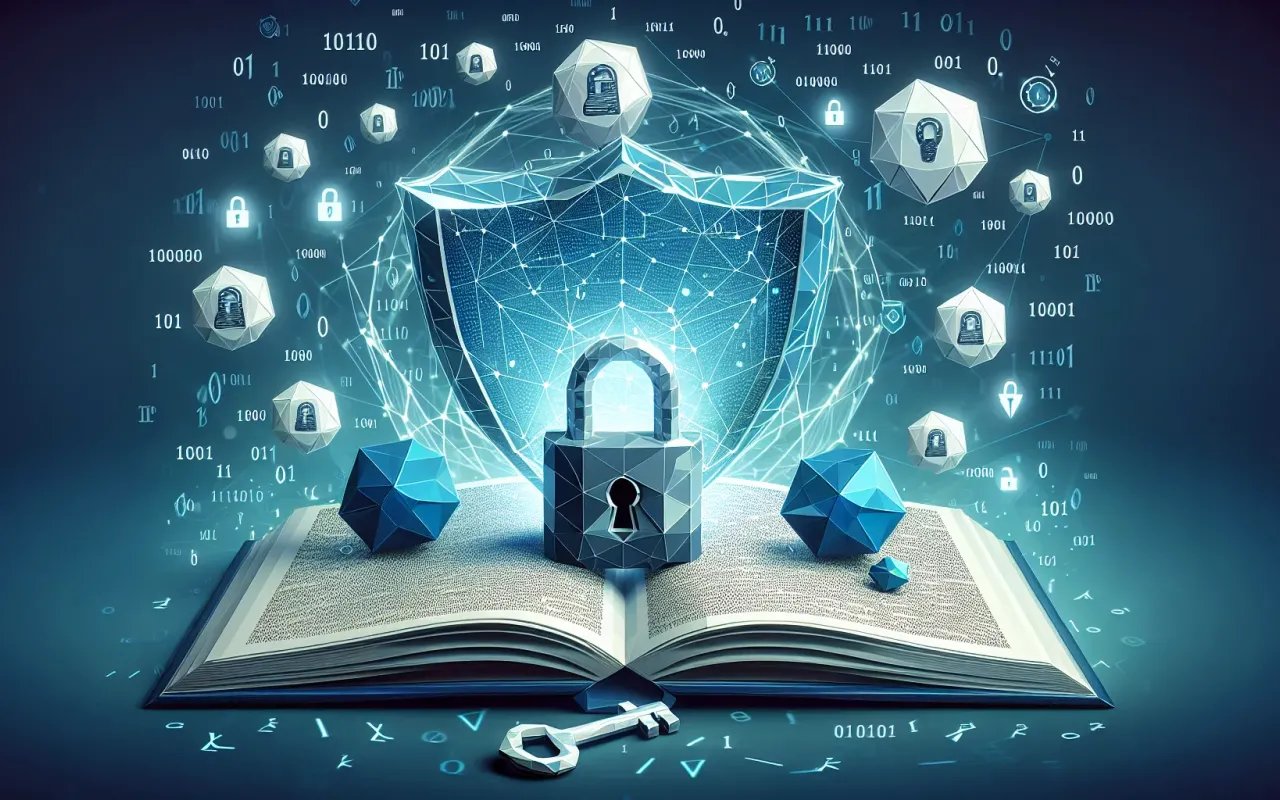

b. AI dalam Keamanan dan Privasi

AI membutuhkan banyak data untuk bekerja, tetapi bagaimana jika data tersebut disalahgunakan?

📌 Contoh:

- AI digunakan untuk memantau aktivitas masyarakat secara berlebihan (pengawasan massal).

- AI yang mengenali wajah digunakan tanpa izin pengguna, melanggar hak privasi.

Regulasi ketat harus diterapkan agar AI tidak digunakan untuk mengawasi masyarakat secara berlebihan.

c. Kemungkinan AI Melampaui Kendali Manusia

Beberapa ilmuwan memperingatkan tentang “Singularity”, yaitu saat AI menjadi terlalu pintar dan manusia tidak bisa lagi mengendalikannya.

📌 Pertanyaan besar:

- Bagaimana jika AI mulai membuat keputusan sendiri tanpa persetujuan manusia?

- Apakah kita bisa mematikan AI jika ia sudah terlalu cerdas?

Ini masih menjadi perdebatan besar di dunia teknologi.

Bagaimana Membangun AI yang Dapat Dipercaya?

a. Regulasi dan Standarisasi AI

🔹 Pemerintah dan organisasi internasional harus membuat regulasi AI yang ketat.

🔹 Contoh: Uni Eropa menerapkan GDPR untuk melindungi data pengguna dari penyalahgunaan AI.

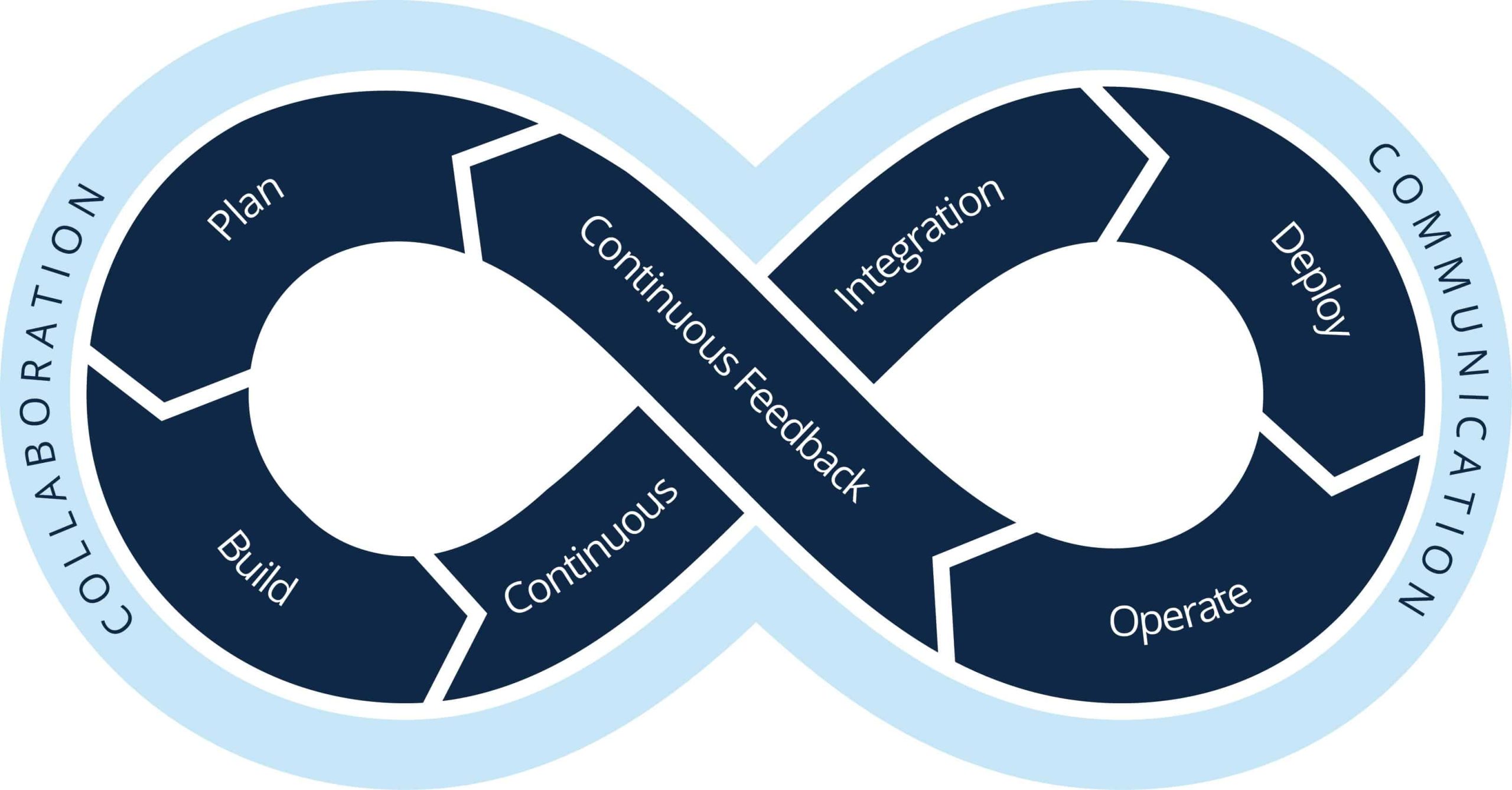

b. Membangun AI yang Transparan dan Bisa Dijelaskan

🔹 Explainable AI (XAI) adalah AI yang bisa menjelaskan bagaimana ia membuat keputusan.

🔹 Transparansi ini sangat penting agar manusia tetap bisa mengawasi dan memahami kerja AI.

c. Mengutamakan Prinsip “Human-in-the-Loop”

🔹 AI sebaiknya tidak bekerja sendiri, tetapi selalu diawasi manusia.

🔹 Dengan sistem ini, AI hanya memberikan rekomendasi, sementara keputusan akhir tetap ada di tangan manusia.

Masa Depan AI dan Kepercayaan terhadap Mesin

AI akan terus berkembang dan menjadi bagian dari kehidupan manusia. Tantangannya adalah:

✅ Bagaimana kita bisa memastikan AI tetap berada dalam kendali manusia?

✅ Bagaimana AI bisa bekerja dengan aman tanpa membahayakan manusia?

✅ Bagaimana kita bisa membuat AI lebih transparan dan adil?

Di masa depan, keseimbangan antara inovasi teknologi dan regulasi yang ketat akan menjadi kunci utama.

Kesimpulan

- AI memiliki potensi besar dalam membantu manusia, tetapi kita harus berhati-hati dalam memberikan kepercayaan penuh pada mesin.

- AI harus transparan, akuntabel, dan bebas dari bias agar dapat bekerja secara adil.

- Regulasi dan pengawasan sangat penting untuk mencegah penyalahgunaan AI.

- Keputusan penting tetap harus ada di tangan manusia, bukan AI.