Pendahuluan

Kecerdasan buatan (AI) belajar dari data — semakin banyak dan berkualitas datanya, semakin pintar hasilnya. Tapi, bagaimana jika data yang dipakai ternyata “beracun”?

Fenomena inilah yang disebut data poisoning. Serangan ini tidak menyerang sistem AI secara langsung, melainkan menanam racun di sumber belajarnya: dataset. Akibatnya, AI bisa membuat keputusan yang salah tanpa disadari siapa pun.

Apa Itu Data Poisoning?

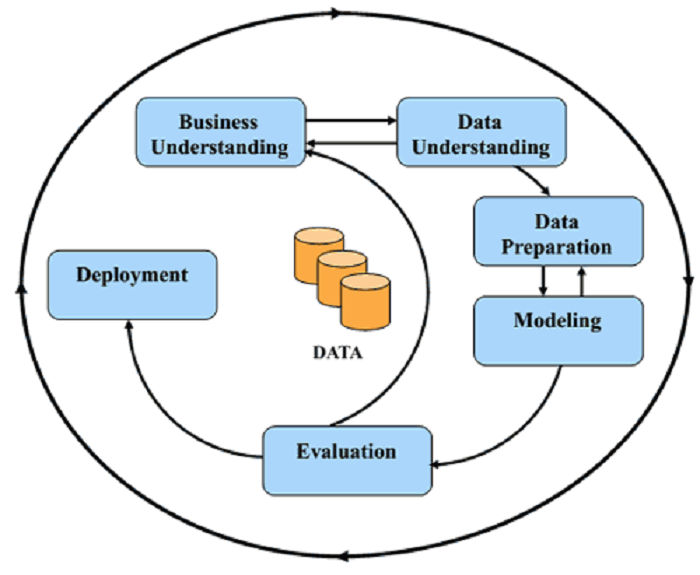

Data poisoning adalah upaya menyisipkan atau mengubah data pelatihan agar model AI belajar sesuatu yang salah.

Tujuannya bisa beragam — mulai dari menurunkan akurasi sistem, membuat hasil yang salah, hingga membuka celah keamanan di masa depan.

Bayangkan seperti guru yang diajari dengan buku pelajaran berisi kesalahan. Murid yang belajar dari guru itu tentu akan salah juga, bukan?

Jenis-Jenis Data Poisoning

-

Label-Flipping Attack

Serangan ini mengganti label data. Misalnya, foto kucing diberi label “anjing”, sehingga model belajar salah. -

Backdoor Attack

Penyerang menyembunyikan pola tertentu (misalnya tanda kecil di gambar) agar nanti, ketika pola itu muncul, AI memberikan hasil yang salah. -

Targeted vs. Untargeted Attack

-

Targeted: Menyerang hasil tertentu saja.

-

Untargeted: Membuat model rusak secara umum.

-

-

Clean-Label Attack

Serangan yang sangat halus — data terlihat normal tapi mengandung manipulasi tersembunyi.

Dampak Data Poisoning

Efek dari data poisoning bisa sangat merugikan:

-

Akurasi menurun: AI jadi sering salah memprediksi.

-

Keamanan terganggu: Penyerang bisa membuat sistem bereaksi sesuai keinginannya.

-

Kerugian bisnis: Rekomendasi produk salah, keputusan analitik meleset, atau reputasi rusak.

-

Contoh sederhana: Sistem penyaring spam bisa gagal membedakan pesan asli dan spam jika datanya sudah dirusak.

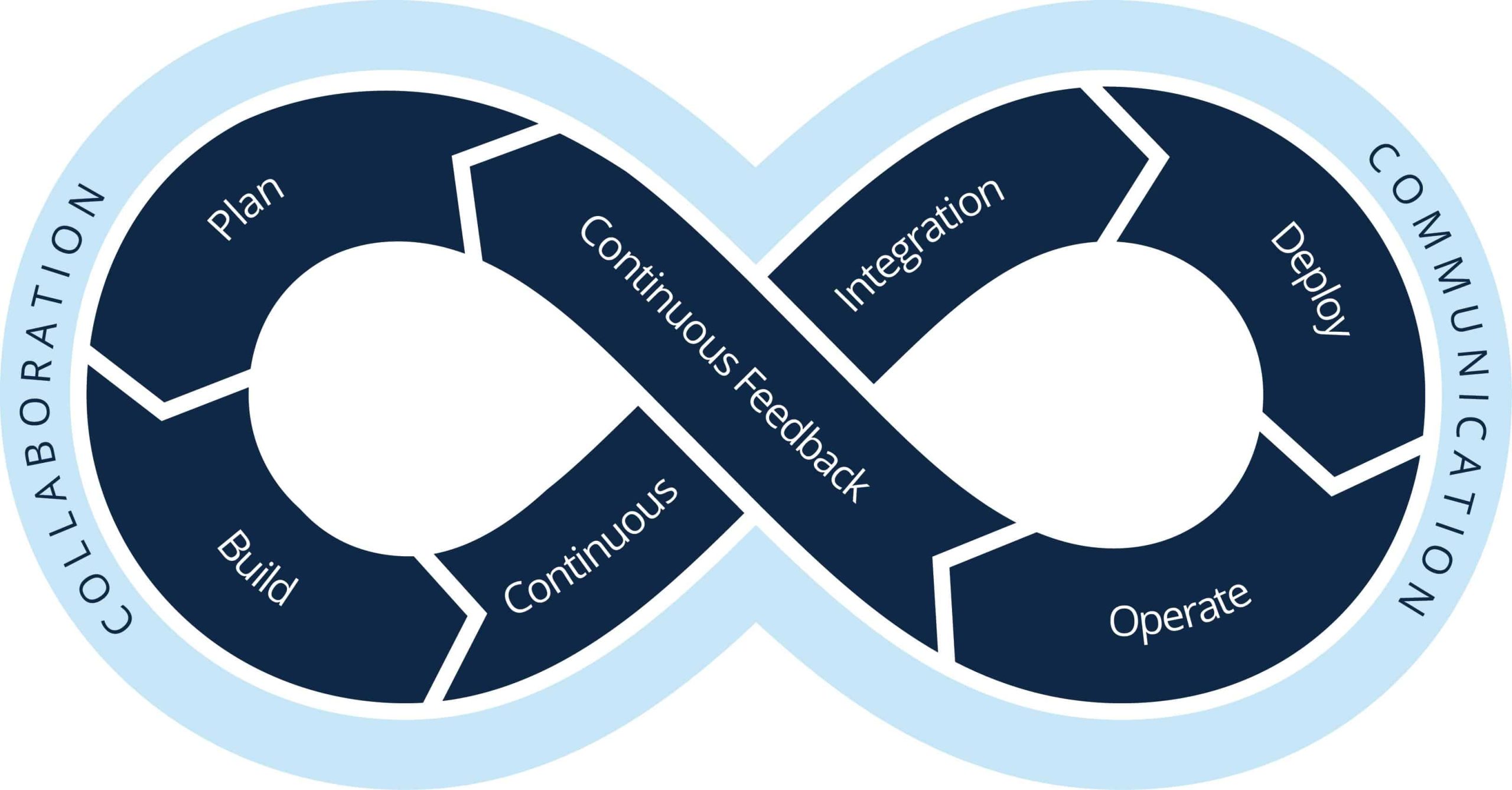

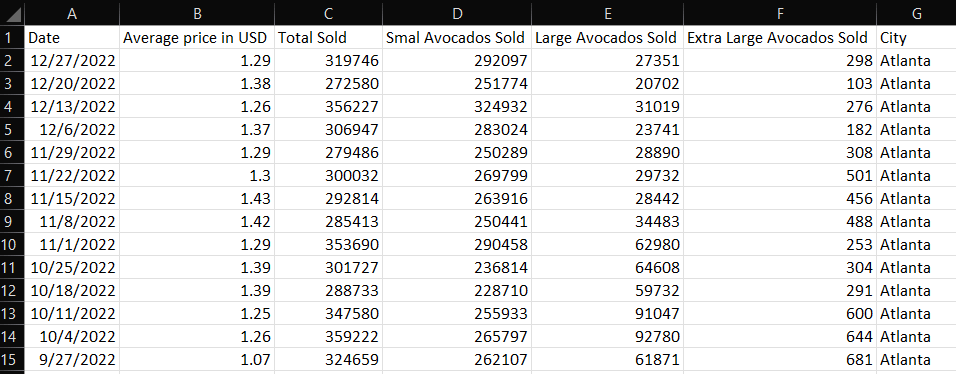

Bagaimana Serangan Ini Terjadi

Proses data poisoning biasanya terjadi secara diam-diam:

-

Penyerang mendapatkan akses ke sumber data (bisa dari dataset publik atau internal).

-

Mereka menyisipkan atau mengubah sebagian data.

-

Model AI kemudian dilatih dengan data yang sudah tercemar.

-

Setelah digunakan di dunia nyata, model mulai menunjukkan perilaku aneh — tapi sering terlambat untuk disadari.

Contoh kasus bisa terjadi di platform open dataset, di mana siapa pun bisa menambahkan data tanpa pemeriksaan ketat.

Strategi Pertahanan dan Mitigasi

Untuk melawan data poisoning, ada beberapa langkah pencegahan penting:

-

Validasi dataset: Selalu periksa keaslian dan keanehan data sebelum dipakai.

-

Robust training: Latih model agar tahan terhadap data aneh atau salah.

-

Data provenance tracking: Catat asal-usul setiap data agar mudah dilacak bila terjadi masalah.

-

Monitoring model: Pantau performa model secara berkala untuk mendeteksi perubahan mencurigakan.

-

Human-in-the-loop: Libatkan manusia dalam proses evaluasi AI untuk memastikan hasil tetap masuk akal.

Kesimpulan

AI hanya sebaik data yang digunakan untuk melatihnya. Jika data tersebut rusak atau dimanipulasi, maka hasilnya pun berbahaya.

Serangan data poisoning menjadi pengingat penting bahwa keamanan AI tidak hanya soal jaringan dan sistem, tetapi juga soal integritas data.

Di era kecerdasan buatan, pertahanan terbaik bukan sekadar firewall — tapi data yang bersih, aman, dan tepercaya.